Pesquisadores usam inteligência artificial em tarefas acadêmicas

Ferramentas dão apoio à escrita, fazem cálculos e até ajudam a escolher revisores

Ferramentas dão apoio à escrita, fazem cálculos e até ajudam a escolher revisores

Esta é uma reprodução da matéria publicada na Revista Pesquisa Fapesp, Edição 352 de junho de 2025 de autoria de Sarah Schmidt.

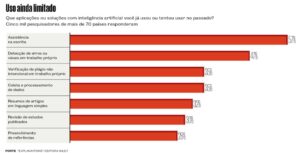

O uso de ferramentas de inteligência artificial (IA) generativa na pesquisa ainda é limitado e se concentra principalmente em tarefas relacionadas à escrita acadêmica, mas há uma percepção majoritária na comunidade científica de que deve se tornar disseminado já nos próximos dois anos, de acordo com um levantamento feito pela editora Wiley, com quase 5 mil pesquisadores de mais de 70 países, entre eles 143 do Brasil (ver infográfico abaixo).

“Há ampla aceitação de que a inteligência artificial vai remodelar o campo da pesquisa”, disse à revista Nature Josh Jarrett, vice-presidente da Wiley e responsável pela área de IA da empresa.

Os entrevistados opinaram se a IA já é capaz de superar os seres humanos em atividades acadêmicas práticas. Mais da metade considerou que a tecnologia produz, sim, resultados melhores do que as pessoas em encargos como mapear possíveis colaboradores, gerar resumos ou conteúdos educacionais a partir de artigos científicos, verificar a existência de plágio em textos, preencher referências bibliográficas ou monitorar a publicação de artigos em áreas determinadas.

Mas, para a maioria dos participantes da pesquisa, os humanos são insubstituíveis em trabalhos como prever tendências, selecionar revistas para publicar artigos, escolher revisores, gerenciar tarefas administrativas e procurar oportunidades de financiamento.

Apesar do interesse crescente, 81% dos entrevistados disseram ter preocupações quanto a possíveis vieses dos resultados, aos riscos à privacidade e à falta de transparência na forma como essas ferramentas são treinadas.

Quase dois terços afirmaram que a falta de orientação e de treinamento os impede de usar a IA tanto quanto gostariam.

“Aqui no Brasil, muitos pesquisadores ainda ficam em dúvida sobre os caminhos éticos para o uso dessas ferramentas e seria importante que órgãos como a Coordenação de Aperfeiçoamento de Pessoal de Nível Superior [Capes] e o Conselho Nacional de Desenvolvimento Científico e Tecnológico [CNPq] criassem diretrizes orientadoras”, afirma o cientista político Rafael Sampaio, da Universidade Federal do Paraná (UFPR), um dos autores de um guia com diretrizes sobre o uso ético e responsável de IA generativa na pesquisa científica, lançado em dezembro em parceria com o administrador de empresas Ricardo Limongi, da Universidade Federal de Goiás (UFG), e com Marcelo Sabbatini, especialista em educação digital da Universidade Federal de Pernambuco (UFPE).

Sampaio utiliza ferramentas de IA em seu trabalho como pesquisador. Um exemplo é uma plataforma do Google, o NotebookLM, que permite ao usuário fazer perguntas sobre temas de pesquisa e obter resumos com base no conteúdo compilado pelo programa. A ferramenta é capaz de “conversar” simultaneamente com até 50 arquivos, como artigos científicos em formatos de PDF, áudio e vídeo – por ora, está disponível gratuitamente.

“Uso esse serviço especialmente quando estou fazendo grandes varreduras, para uma primeira triagem e para selecionar o que vou ler de fato. Também ajuda quando preciso localizar rapidamente algum artigo que já li, mas não me lembro do título ou do autor”, conta. Uma funcionalidade do programa que impressiona os usuários são os resumos em formato de podcast com duas pessoas conversando – tudo gerado por IA – acerca dos arquivos analisados.

O guia reúne e descreve uma série de ferramentas que, a exemplo do NotebookLM, podem ser úteis aos pesquisadores, sempre fazendo a ressalva de que a checagem humana é essencial em todos os processos em que elas forem usadas, colocando a IA como uma assistente. Limongi, coautor do manual, utiliza com frequência dois softwares que ajudam a fazer a revisão da literatura em determinados temas – LitMaps e Scite. Eles permitem carregar um artigo científico em PDF e gerar mapas interativos, mostrando as conexões do trabalho com outros papers, além de mostrar os links e identificar referências precisas para aprimorar a argumentação.

Limongi ressalta que é preciso treinar pesquisadores para que conheçam as limitações das ferramentas e adverte que o uso excessivo e sem um olhar crítico desses softwares pode fazer com que os futuros cientistas atrofiem habilidades essenciais, como fazer leituras complexas e organizar ideias em um texto articulado. “A IA é uma auxiliar, mas o pesquisador é quem planeja e conduz seu estudo. Ele não deve ser um apertador de botão”, reforça. Periódicos científicos não permitem que ferramentas de IA sejam consideradas autoras de trabalhos acadêmicos – o humano é sempre o responsável pelos resultados científicos e pelos textos que elabora com esse auxílio.

A Claude.ai, um chatbot (programa de IA que simula conversas humanas) concorrente do ChatGPT, pode ser útil para gerar estruturas de textos. A plataforma tem sido usada por Sabbatini, da UFPE, para desenvolver a estrutura inicial e revisar textos acadêmicos e de divulgação científica. “Peço sugestões de como abordar um tema e, depois, quais seriam os caminhos para desenvolvê-lo. A ferramenta cria uma estrutura e eu vou dialogando com ela, buscando, checando e complementando com meu conhecimento e visão pessoais.”

Criada pela startup norte-americana Anthropic, a ferramenta foi a mais bem avaliada em um estudo, publicado em maio na revista Royal Society Open Science, que analisou a capacidade de 10 programas de IA generativa, incluindo o ChatGPT e o DeepSeek, de gerar resumos fidedignos sobre artigos científicos. O resultado geral do trabalho, contudo, foi desfavorável para o conjunto dos chatbots, que produziram conclusões imprecisas ou exageradas em até 73% dos 5 mil artigos científicos resumidos.

O engenheiro de materiais Edgar Dutra Zanotto, pesquisador da Universidade Federal de São Carlos (UFSCar), usa chatbots como o ChatGPT, DeepSeek, Claude, Perplexity e Gemini para múltiplas tarefas. As ferramentas o auxiliam, por exemplo, a revisar textos em inglês, a fazer cálculos (como calcular a composição molar de um vidro a partir do peso molecular dos elementos) e a selecionar possíveis revisores para artigos científicos da revista Journal of Non-Crystalline Solids, da qual é editor. “Levanto quem são os pesquisadores mais influentes no tópico que preciso”, conta.

Zanotto já tinha experiência com inteligência artificial na área de aprendizado de máquina: ele e seu grupo no Centro de Pesquisa, Educação e Inovação em Vidros (CeRTEV), um dos Centros de Pesquisa, Inovação e Difusão (Cepid) financiados pela FAPESP, treinaram um algoritmo com dados de 55 mil composições de vidro, um banco de dados com um volume inédito na área, que é capaz de sugerir estruturas que nunca foram criadas. Antes da IA, o desenvolvimento de novas composições era feito por tentativa e erro. “Com isso, é possível criar um novo vidro em um mês. Antigamente, levava anos e qualquer novo vidro virava uma tese”, diz.

Há usos da inteligência artificial para soluções matemáticas, que podem ser feitas em programas como o MathGPT. Há também aquelas que podem ser utilizadas como auxiliares na programação. “Claude e o Gemini têm sido muito usados tanto para gerar quanto para avaliar códigos”, observa Limongi.

Como essas ferramentas são treinadas por bancos de dados de informações já existentes na internet, elas podem reproduzir vieses. Às vezes, também geram “alucinações”, inventando termos, nomes e referências. Para evitar esses problemas, Zanotto, por exemplo, testa as respostas de que precisa em mais de um chatbot, a fim de cruzar os dados e chegar a informações mais confiáveis.

Uma das vocações de programas de uso popular como o ChatGPT é o brainstorming, ou exploração inicial de ideias, graças à capacidade deles de rastrear e combinar informações em gigantescos bancos de dados. Em uma “conversa” com a ferramenta, o pesquisador pode pedir sugestões de caminhos que poderia seguir sobre determinado tema. É preciso, no entanto, avaliar as possibilidades, uma vez que algumas ideias podem não ser exclusivas, já que os modelos são treinados com informações que já existem, embora também sejam capazes de sugerir novas variações.

O engenheiro de produção Roberto Antonio Martins, da UFSCar, tem experimentado softwares como o ChatGPT, o Copilot e o DeepSeek, usando a função de pesquisa profunda (deep research), incorporada recentemente a essas ferramentas. A funcionalidade faz buscas avançadas na web, inclusive em fontes acadêmicas, e gera relatórios, com uma síntese do tema e uma lista de fontes das informações levantadas, ele explica.

Nesse tipo de pesquisa, a ferramenta costuma fazer perguntas ao usuário antes de iniciar sua varredura e, assim, cria um prompt (comando dado pelo usuário para gerar uma resposta) bem estruturado. Martins sempre começa essa etapa com um questionamento à ferramenta sobre o tema que precisa explorar. “Não é uma busca por palavra-chave, como costumávamos fazer, mas por uma pergunta, e, diferente de palavras-chaves, uma pergunta tem mais contexto e pode trazer resultados mais precisos”, observa Martins, que tem ministrado palestras sobre o uso de IA generativa na pesquisa acadêmica.

É preciso treinar pesquisadores sobre as limitações da IA

O chatbot Perplexity conquistou usuários do mundo acadêmico por fornecer informações baseadas nos resultados mais recentes da internet e exibir notas de rodapé clicáveis nas fontes de onde foram extraídas as informações. “Uso essas ferramentas quando começo a levantar informações e a criar hipóteses sobre um novo tema de pesquisa”, diz a brasileira Cyntia Calixto, professora de negócios internacionais na Leeds University Business School, no Reino Unido, que tem usado esses programas em sua pesquisa sobre o ativismo dos CEO de empresas que se posicionam sobre temas polêmicos nas redes sociais. “A IA funciona como um assistente, com quem vou discutir um tema conforme vou explorando.”

Quando a tarefa é localizar artigos científicos de interesse do pesquisador, uma opção que Calixto costuma usar é a SciSpace, que faz a busca de papers e apresenta um resumo de cada um deles. O biomédico Aydamari Faria-Jr., da Universidade Federal Fluminense (UFF), destaca outras duas ferramentas, a Answer This e a Elicit, que permitem explorar múltiplas bases de dados científicos, como o PubMed e Scopus. “Elas oferecem filtros que otimizam o processo de busca e permitem restringir a procura, por exemplo, a ensaios clínicos randomizados, revisões sistemáticas com ou sem meta-análises ou trabalhos transversais”, observa. Ele costuma complementar o trabalho com a consulta manual às bases de dados, com o intuito de garantir uma varredura ampla sobre o tema que está pesquisando no momento.

O apoio de programas de inteligência artificial na escrita de artigos se estende a questões ligadas à integridade científica, como avaliar se as citações contidas em um paper são robustas e fidedignas. A plataforma Scite exibe o contexto original de uma citação de um artigo científico e mostra, por meio de uma classificação realizada por um modelo de aprendizado profundo, se ela se apoia mesmo no texto de referência ou se contrasta com seu conteúdo. A advogada Cristina Godoy, da Faculdade de Direito de Ribeirão Preto (FDRP-USP), costuma usar a ferramenta.

Por meio dela, encontrou um artigo publicado na revista Nature que complementou um trabalho de sua autoria sobre inteligência artificial. “A plataforma indica artigos científicos que dialogam com o tema e aponta o link para o paper. E dá para escolher o periódico no qual se quer fazer a busca”, conta ela, que costuma usar outras ferramentas de IA para analisar dados. Godoy toma um cuidado especial ao utilizar programas de inteligência artificial generativa: jamais faz buscas utilizando trechos de trabalhos que ainda não foram publicados, porque sabe que esse conteúdo pode ser usado para treinar a ferramenta – e nunca se sabe se as ideias podem parar nos resultados de pesquisas de outros usuários.

A reportagem acima foi publicada com o título “Assistente virtual” na edição impressa nº 352, de junho de 2025.

Imagens: Julia Jabur

Este texto foi originalmente publicado por Pesquisa FAPESP de acordo com a licença Creative Commons CC-BY-NC-ND. Leia o original aqui.